Linjär algbra: Yttre proukt av linjär avbildning

Hej, se fråga och facit:

Visa spoiler

Men vad betyder egentligen ? Man kan ta yttre produkt av vektorer och vektorrum, men linjära avbildningar...?

(Linjära avbildningar är vektorer i Hom( . , .), men det är inte det som sker här tror jag)

bump?

Seriouscephalopod jag ser att du skriver men du tvekar, det gör inget om det bara är en gissning, det kanske räcker! Anythings more than i got

Yttre produkt-konstruktionen är en funktor, vilket betyder att den går att applicera både på vektorrum och på linjära avbildningar mellan vektorrum (på ett sådant vis att den respekterar både identitetsavbildningar och funktionssammansättning).

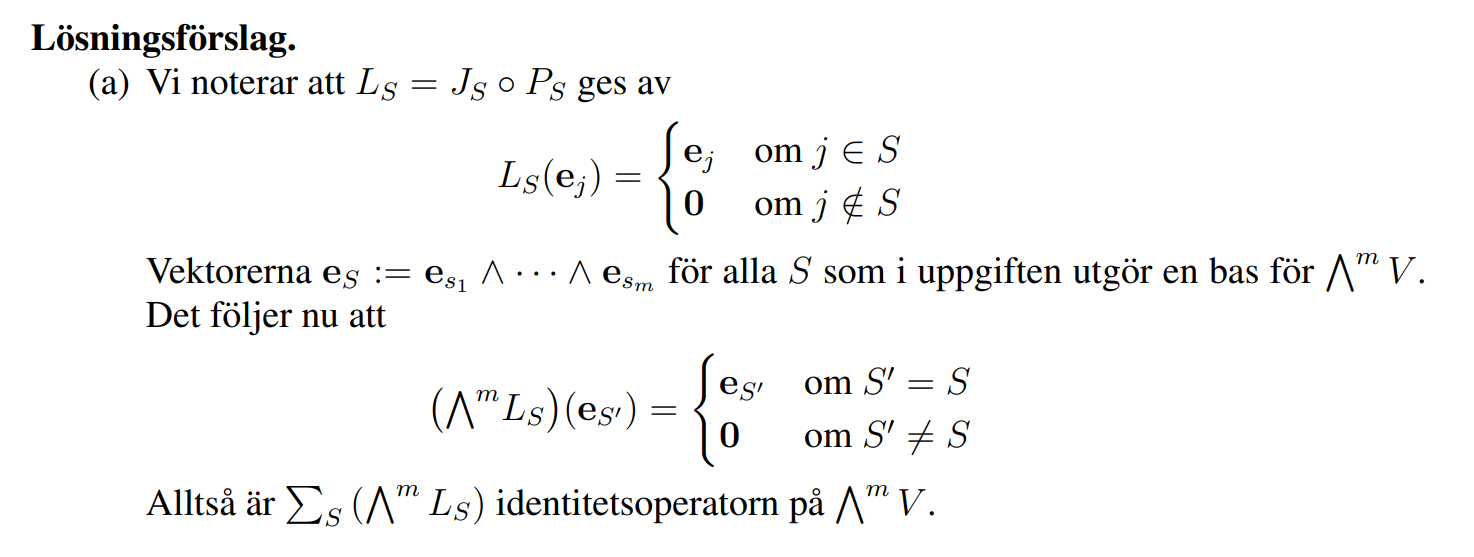

Mer precist så gäller följande: Låt och vara ett vektorrum över någon kropp , och låt vara en linjär avbildning. Kom ihåg att kan betraktas av mängden av alla linjärkombinationer av "ord" på formen , där vi har infört multilinjäritet och bestämt att ord med två likadana vektorer bredvid varandra sätts till . Motsvarande gäller för . Den inducerade linjära avbildningen definieras nu av att vi sätter

för varje enskilt ord, och sedan utvidgar linjärt. Jämför gärna detta med diskussionen i din tråd om den yttre algebran.

Frågan du nu behöver ställa dig är vad gör på varje basvektor (för indexmängder med ).

Visa spoiler

Vi får att , där som tidigare har konstaterats har egenskapen att den för varje basvektor kontrollerar om - om ja så låter den basvektorn vara, och om nej så förintas basvektorn i fråga!

Tack vare multilinjäriteten hos så räcker det med att minst en av faktorerna är för att hela produkten ska bli , så det är ganska enkelt att se (tänk efter noggrant här!) att

precis som facit säger!